Ollama 安装部署教程,一键搭建本地deepseek-R1大模型

一、Ollama介绍

1、基本介绍

Ollama是一个支持在Windows、Linux和MacOS上本地运行大语言模型的工具。它允许用户非常方便地运行和使用各种大语言模型,比如Qwen模型等。用户只需一行命令就可以启动模型。

主要特点包括:

- 跨平台支持

Windows、Linux、MacOS系统。 - 提供了丰富的模型库,包括

Qwen、Llama等1700+大语言模型,可以在官网model library中直接下载使用。 - 支持用户上传自己的模型。用户可以将

huggingface等地方的ggml格式模型导入到ollama中使用。也可以将基于pytorch等格式的模型转换为ggml格式后导入。 - 允许用户通过编写

modelfile配置文件来自定义模型的推理参数,如temperature、top_p等,从而调节模型生成效果。 - 支持多

GPU并行推理加速。在多卡环境下,可以设置环境变量来指定特定GPU。 - 强大的技术团队支持,很多模型开源不到24小时就能获得支持。

总的来说,Ollama降低了普通开发者使用大语言模型的门槛,使得本地部署体验大模型变得简单易行。对于想要搭建自己的AI应用,或者针对特定任务调优模型的开发者来说,是一个非常有用的工具。它的一些特性,如允许用户自定义模型参数,对模型进行个性化适配提供了支持。

2、官网

- Ollama 下载:https://ollama.com/download

- Ollama 官方主页:https://ollama.com

- Ollama 官方 GitHub 源代码仓库:https://github.com/ollama/ollama/

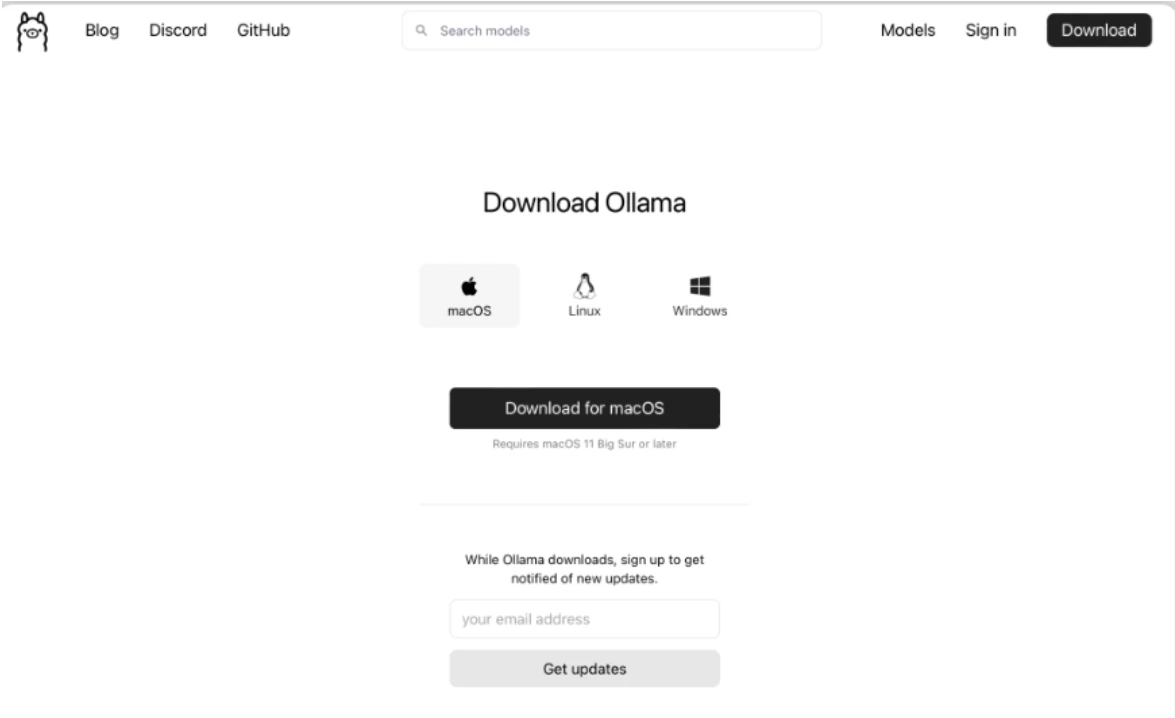

二、window 安装

直接从下载页面下载相对应系统的安装程序,Windows安装程序选择Windows的安装包,点击“Download for Windows(Preview)”

下载好以后一路install 安装即可。(默认安装在C盘,想要安装在任意盘看下面教程)

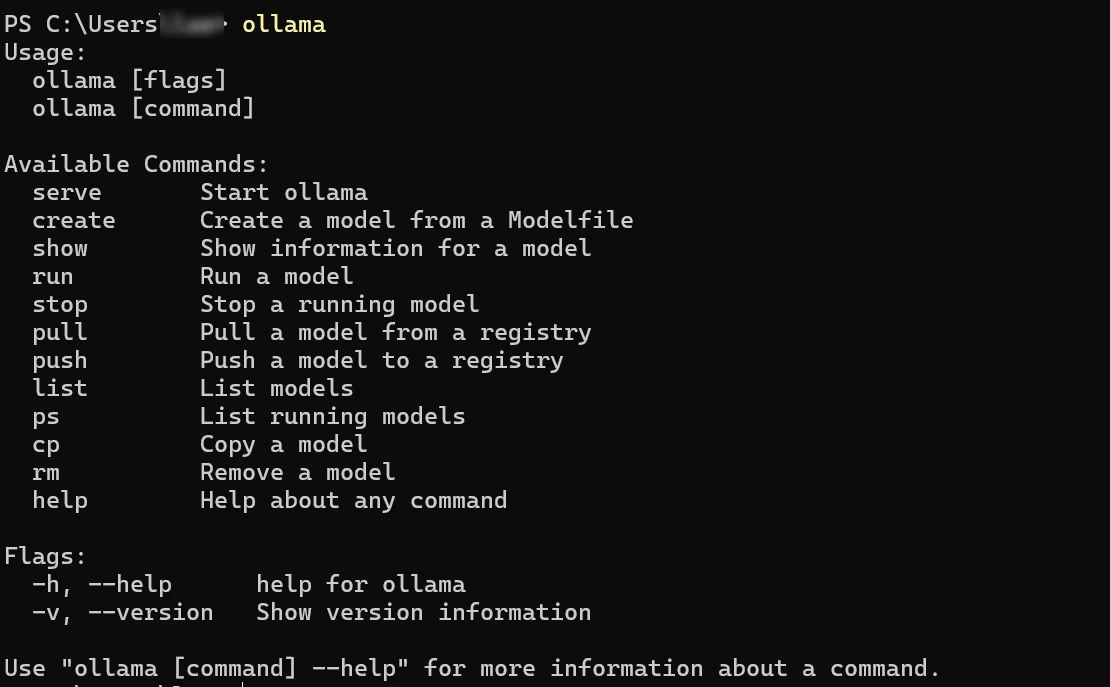

安装完成之后,打开一个cmd命令窗口,输入“ollama”命令,如果显示ollama相关的信息就证明安装已经成功了!

三、Mac 安装

直接从下载页面下载相对应系统的安装程序,Windows安装程序选择Windows的安装包,点击“Download for Mac”

下载好后打开安装命令行

四、命令参数

以下是 Ollama 使用常见的指令:

ollama serve #启动ollama

ollama create #从模型文件创建模型

ollama show #显示模型信息

ollama run #运行模型

ollama pull #从注册表中拉取模型

ollama push #将模型推送到注册表

ollama list #列出模型

ollama cp #复制模型

ollama rm #删除模型

ollama help #获取有关任何命令的帮助信息

五、设置自定义模型下载路径

默认情况下,ollama模型的存储目录如下:

- macOS:

~/.ollama/models - Linux:

/usr/share/ollama/.ollama/models - Windows:

C:\Users\<username>\.ollama\models

1、Windows 更改 Ollama 模型存放位置

在Windows系统中,若要更改Ollama模型的存放位置,可以按照以下步骤操作:

- 打开环境变量编辑界面。可以通过以下方式:

- 右键点击“此电脑”或“我的电脑”,选择“属性”。

- 在系统窗口中选择“高级系统设置”。

- 在系统属性窗口中点击“环境变量”按钮。

- 在环境变量窗口中,点击“新建”创建一个新的系统变量或用户变量。

- 变量名:

OLLAMA_MODELS - 变量值:输入你希望设置的新模型存放路径,例如:

D:\Ollama\Models

- 点击“确定”保存设置。

- 重启任何已经打开的Ollama相关应用程序,以便新的路径生效。

六、windows自定义安装到其他盘

如果你想将 Ollama 应用程序安装到 E 盘的 Ollama 文件夹中,你可以按照以下步骤操作: 首先,确保 E 盘的 Ollama 文件夹已经存在。如果不存在,你需要先创建这个文件夹。你可以在文件资源管理器中手动创建,或者使用命令提示符创建: 打开命令提示符(cmd),然后输入以下命令来创建文件夹: 复制 E: mkdir Ollama 接下来,打开命令提示符。 使用 cd 命令切换到 OllamaSetup.exe 所在的目录。如果 OllamaSetup.exe 直接位于 E 盘的根目录,你可以使用以下命令: E: 这会将命令提示符的当前目录切换到 E 盘。 运行安装程序并指定安装目录。例如,要将 Ollama 安装到 E:\Ollama,你可以输入以下命令: OllamaSetup.exe /DIR="E:\Ollama" 请确保使用双引号将路径括起来,特别是当路径中包含空格时。 按下回车键,安装程序将开始运行,并按照你指定的路径进行安装。

七、部署下载大模型

进入官网

- Ollama 官方主页:https://ollama.com

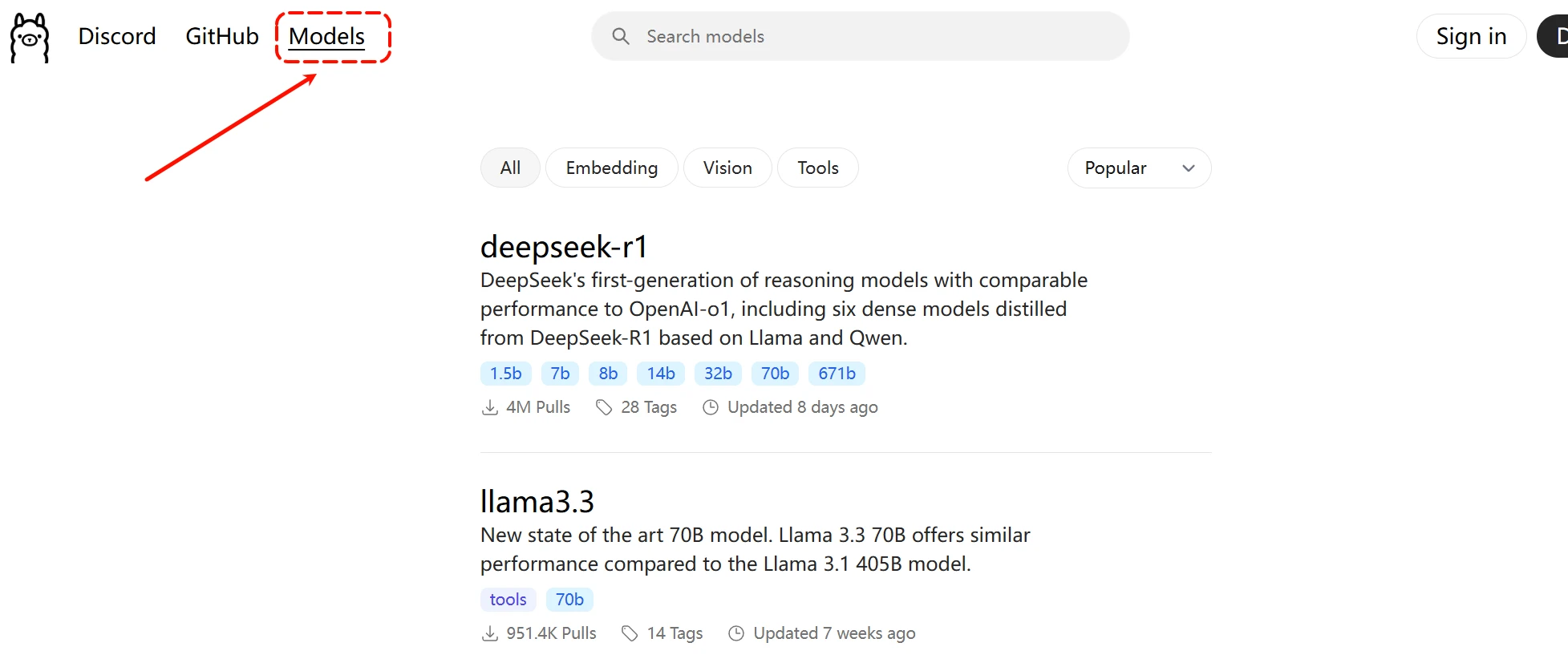

选择models一栏

里面就有各种可以下载的大模型,点击选择deepseek-r1

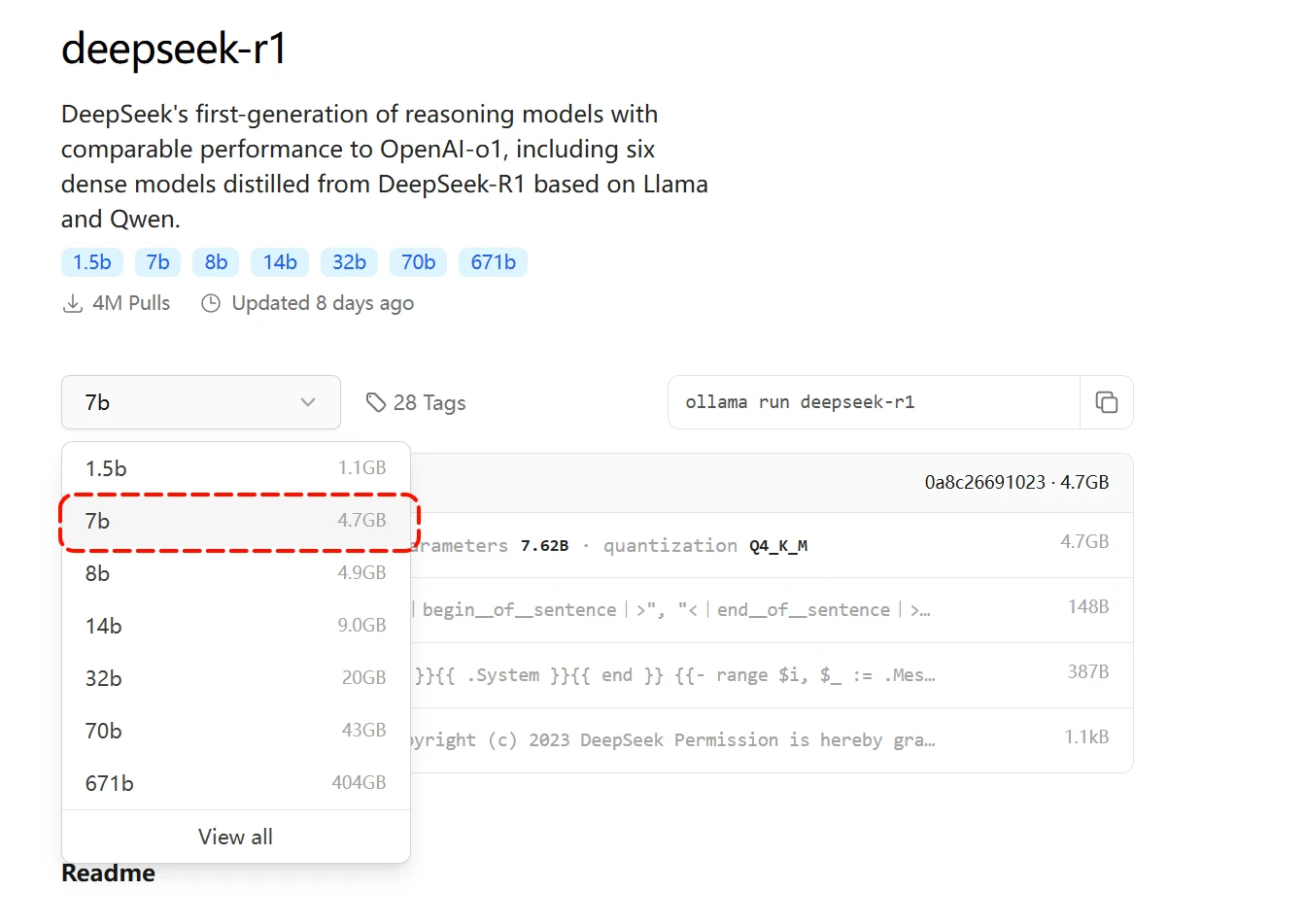

选择一个你要下载的大模型,这里我选择一个7b的模型,模型数值越大代表的参数越多,运行起来也就消耗越大,量力而行。

然后复制一下右边的下载命令,到终端窗口去运行

然后就是等待下载

看到success就是下载成功了,这时他会自动开始运行,已经在本地部署成功了。

现在就可以和他对话了

八、退出之后如何再次启动本地的大模型

在开始菜单选择Ollama,然后点击运行

在左下角出现一个羊驼的标志,就是运行成功了

打开终端,power shell

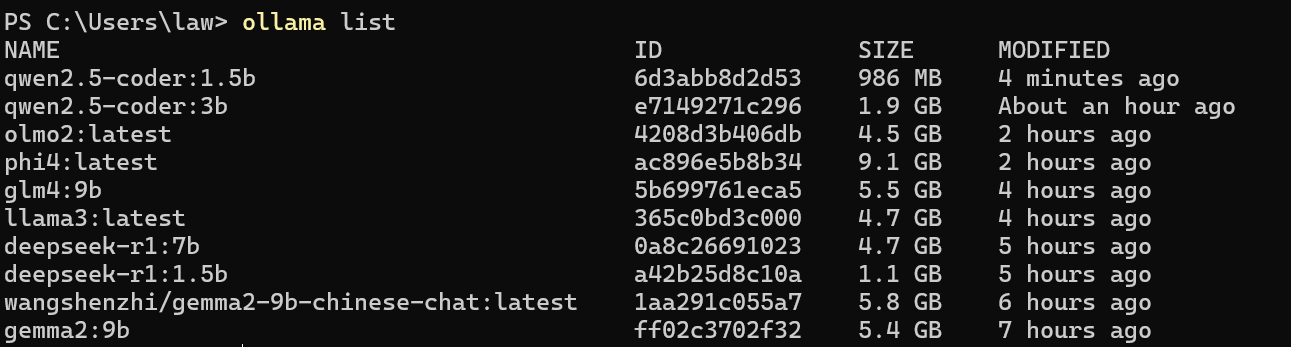

查看已经按照的模型:输入命令 ollama list ,会列出你所下载的模型

然后直接输入 ollama run +模型的名称,例如 ollama run deepseek-r1:7b ,即可启动成功

2025-01-30如有失效,请留言